Den meisten Menschen sagt der Name Nvidia wahrscheinlich nicht viel – außer Videospieler*innen. Seit 1993 steht Nvidia an der Spitze des Marktes für Videospiel-Hardware und hat eine Reihe von High-End-Grafikkarten für Spiele-PCs und Konsolen entwickelt.

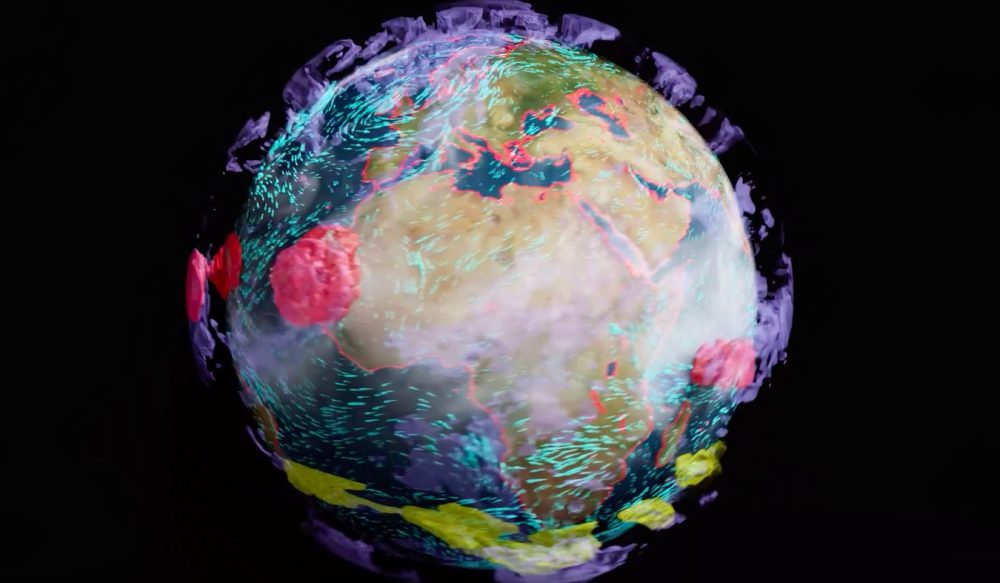

Neuerdings will das in den USA ansässige Unternehmen sein Fachwissen in Sachen Simulation und Rechenleistung auch für den Umweltschutz einsetzen: Nvidia kündigte kürzlich Earth-2 an, einen neuen Supercomputer, der die Erde angeblich bis auf einen Meter genau realistisch modellieren kann. Das Projekt befindet sich noch in der Entwicklungsphase, aber solche Computersimulationen könnten in Zukunft die Klimaforschung und die Umweltpolitik erheblich unterstützen.

Ganz neu sind Computersimulationen der Erde nicht; schon ab 1999 wurden Projekte wie die Earth Simulator-Reihe in Japan entwickelt. Doch derzeit haben die meisten Klimasimulationen eine Auflösung von etwa 10 bis 100 Kilometern. Für weitreichende Wettermuster und -systeme ist das durchaus nützlich, aber damit wird nicht unbedingt das gesamte Spektrum unserer Umweltprobleme erfasst.

Mit einer Auflösung im Metermaßstab könnte Earth-2 theoretisch Elemente wie den globalen Wasserkreislauf und die Veränderungen, die zu immer stärkeren Stürmen und Dürren führen, genauer simulieren. Denkbar ist damit auch, dass Länder und Städte Frühwarnungen über Klimaereignisse erhalten oder Infrastrukturverbesserungen und Notfallmaßnahmen auf Ebene einzelner Straße oder sogar einzelner Gebäude planen können. Solche Simulationen können mit Jahrzehnte abdeckenden Klimadaten verknüpft werden und Forschenden einen umfassenden „digitalen Zwilling“ der Erde liefern, mit dem sie experimentieren können, etwa um zu untersuchen, wie Wolken das Sonnenlicht zurückwerfen.

KÜNSTLICHE INTELLIGENZ – KÖNNEN WIR MIT RECHENLEISTUNG UNSEREN PLANETEN RETTEN?

Wo werden KI-Anwendungen schon jetzt im Umwelt- und Klimaschutz eingesetzt? Worin bestehen besondere Chancen, aber auch Risiken in Bezug auf ökologische und soziale Aspekte? Und wie sehen zukünftige KI-Entwicklungen mit einem echten Mehrwert für Umwelt und Klima aus? Hier findest du Antworten.

Um diese neue Auflösung zu erreichen, wären Maschinen mit einer millionen- bis milliardenfachen Rechenleistung erforderlich, als derzeit verfügbar ist. Doch da die Rechenleistung im Allgemeinen alle fünf Jahre um das Zehnfache steigt, bräuchte es Jahrtausende, bis dies erreicht wäre. Laut Nvidia ist dieser gigantische Sprung jedoch möglich – wenn verschiedene Technologien und Disziplinen kombiniert werden. Durch die Kombination von GPU-beschleunigtem Rechnen (Nvidias Kernkompetenz) mit Deep Learning, künstlicher Intelligenz und physikalisch informierten neuronalen Netzen können riesige Informationsmengen durch riesige, raumgroße Supercomputer geleitet werden.

Earth-2 soll dann in die Omniverse-Plattform von Nvidia (nicht zu verwechseln mit dem „Metaverse“) eingebunden werden, eine offene Plattform, die für die virtuelle Zusammenarbeit und physikalisch exakte Echtzeitsimulationen entwickelt wurde. Obwohl diese in erster Linie auf den Hauptmarkt von Nvidia – Videospiele und Medien – ausgerichtet ist, können solche leistungsstarken Simulationen auch in der wissenschaftlichen Forschung, der Architektur, dem Ingenieurwesen und der Fertigung eine wichtige Rolle spielen. Durch die Bereitstellung über Omniverse könnte sie laut Nvidia zu einem unverzichtbaren Werkzeug für zahlreiche KI- und andere Tech-Startups auf der ganzen Welt werden.

Nvidia hat bereits einige Erfahrung in diesem Bereich. Anfang dieses Jahres stellte das Unternehmen Cambridge-1 vor, einen 100 Millionen US-Dollar teuren Supercomputer, der in Großbritannien gebaut wurde. Cambridge-1 wurde in nur 20 Wochen gebaut – im Gegensatz zu den zwei Jahren, die Supercomputer normalerweise benötigen – und soll eine kollaborative Simulationsplattform für die Gesundheitsforschung, Universitäten und Krankenhäuser bieten.

Der Aufstieg der Supercomputer-Simulationen

Bei Supercomputern handelt es sich im Wesentlichen um Computer mit einer extrem hohen Leistung im Vergleich zu einem normalen Desktop-Computer. Während die meisten Computer für Endverbraucher*innen in „Millionen von Instruktionen pro Sekunde (MIPS)“ angegeben werden, werden Supercomputer nach „Gleitkommaoperationen pro Sekunde (FLOPS)“ eingestuft. Vereinfacht ausgedrückt sind Supercomputer hunderttausendmal schneller und leistungsfähiger als ein normaler Computer, wobei die leistungsfähigsten Supercomputer bis zu 27.000 Billionen Berechnungen pro Sekunde durchführen können.

Diese Leistung wird benötigt, wenn immer komplexere Simulationen durchgeführt werden sollen, wie zum Beispiel die Physik des Weltraums, die Quantenmechanik oder die Kernspaltungsforschung. Mit der Weiterentwicklung der Technologie können diese Simulationen in immer größeren Auflösungen und Maßstäben durchgeführt werden. In den 1960er Jahren war die Klimamodellierung nur für die Ozeane und die Landvegetation möglich. Inzwischen wurden Modelle u. a. für die Bewegung der Eisschilde, die Atmosphärenchemie, marine Ökosysteme, biochemische Zyklen und die Ausbreitung von Aerosolen entwickelt.

Das Plymouth Marine Laboratory nutzt beispielsweise den Supercomputer Massive GPU Cluster for Earth Observation (MAGEO), mit dem Waldbrände vorhergesagt, Ölverschmutzungen und Plastik aufgespürt sowie Mangroven und die Artenvielfalt kartiert werden kann. Heute gibt es weltweit etwa 500 Supercomputer mit unterschiedlicher Leistung.

Supercomputer sind aber nicht nur in Bezug auf ihre Rechenleistung „super“, sondern auch in Bezug auf ihre Größe. Normalerweise bestehen Supercomputer aus großen Bänken von Prozessoren und Speichermodulen, die über Hochgeschwindigkeitsverbindungen miteinander vernetzt sind. Die größten Supercomputer nutzen auch die Parallelverarbeitung, die es einem Computer ermöglicht, mehrere Teile eines Problems gleichzeitig zu bearbeiten. Dies bedeutet, dass Supercomputer in der Regel die Größe ganzer Zimmer haben.

Doch all diese Rechenleistung ist auch mit einem enormen Energiebedarf und großen Mengen an Abwärme verbunden. Das bedeutet, dass Supercomputer selbst nicht unbedingt die umweltfreundlichsten Forschungsinstrumente sind. Der japanische Supercomputer Fugaku zum Beispiel verbraucht mehr als 28 Megawatt Strom, um seine Aufgabe zu erfüllen. Das entspricht der Leistung von zehntausenden von Haushalten in den Vereinigten Staaten. Australische Astronomen haben errechnet, dass die Nutzung von Supercomputern ihr größter Kohlenstoffproduzent ist, dreimal so viel wie das Fliegen. Natürlich hängt die Menge der CO2-Emissionen davon ab, wie der Strom in einem Land erzeugt wird; Supercomputer, die mit erneuerbarem Strom gespeist werden pusten weniger CO2 in die Atmosphäre.

Es werden jedoch Schritte unternommen, um die Energieeffizienz zu verbessern. Effizientere Codes bedeuten zum Beispiel, dass weniger Rechenleistung benötigt wird, was den Energiebedarf senkt, während der Bau von Supercomputern an kühleren Orten wie Island bedeutet, dass die überschüssige Wärme für andere Zwecke genutzt werden kann.

Gleichzeitig darf nicht vergessen werden, dass der Energieverbrauch von Supercomputern im Vergleich zur allgemeinen Computernutzung verschwindend gering ist. Wie Dan Stanzione, Geschäftsführer des Texas Advanced Computing Center an der University of Texas in Austin, erklärt:

„Supercomputer machen auch nur einen winzigen Teil der gesamten Computernutzung aus. Allein die großen Rechenzentren in den Vereinigten Staaten würden etwa 60 Millionen Tonnen ausstoßen, d. h. alle Supercomputer der Welt würden weniger als 5 Prozent der Energie verbrauchen, die wir für E-Mails und das Streaming von Katzenvideos verwenden.“